ollama操作指南

一、如何在windows系统上安装 ollama

一.下载 Ollama 访问 https://ollama.com/download ,选择 Windows,单击 “Download for Windows (Preview)” 进行下载。

二. 安装 Ollama

双击下载的 “OllamaSetup.exe”,进行安装。

三. 环境变量

Ollama 下载的模型默认保存在 C 盘。

强烈建议更改默认路径,可以通过新建环境变量 OLLAMA_MODELS 进行修改。

- 变量名:OLLAMA_MODELS

- 变量值:E:\OllamaCache

设置成功后重启电脑生效修改

二、如何使用 Ollama 启动大模型服务

搜索需要使用的模型,主流的模型。

再下面以 qwen2 为例,选择运行 1.5b 的模型

在cmd或者PowerShell运行(推荐使用cmd)

ollama run qwen2:1.5b

等待模型下载与加载。

当出现 Send a nessage 即可开始模型的使用

三、如何调用大模型 API 服务

打开chrome浏览器访问页面

http://localhost:11434/

返回 Ollama is running 说明API服务正常

单轮对话使用样例

import requests

import json

url = 'http://localhost:11434/v1/chat/completions'

headers = {

'Content-Type': 'application/json'

}

data = {

"model": "qwen2:1.5b",

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Hello!"

}

]

}

response = requests.post(url, headers=headers, data=json.dumps(data))

print(response.json())

多轮对话使用样例

import requests

import json

url = 'http://localhost:11434/v1/chat/completions'

headers = {

'Content-Type': 'application/json'

}

data = {

"model": "qwen2:1.5b",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Who won the world series in 2020?"},

{"role": "assistant", "content": "The LA Dodgers won in 2020."},

{"role": "user", "content": "Where was it played?"}

]

}

response = requests.post(url, headers=headers, data=json.dumps(data))

print(response.json())

详细操作,请参考官方文档

四、如何部署web界面

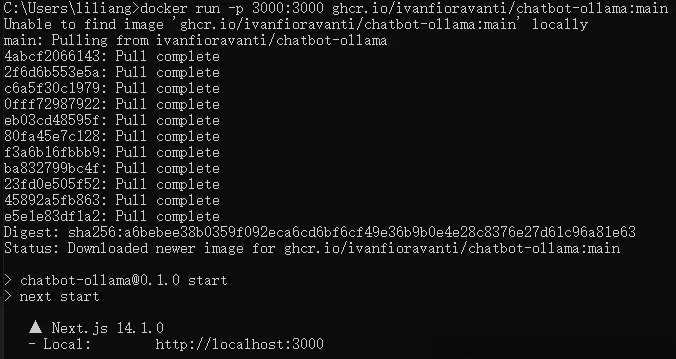

下面我们部署一个类似ChatGPT界面的web ui,运行以下docker命令。

docker run -p 3000:3000 ghcr.io/ivanfioravanti/chatbot-ollama:main

如下图所示,一键部署成功。

用浏览器打开http://localhost:3000,即可像使用ChatGPT一样使用自己的私有GPT了,重点是可以离线使用,数据更安全!

「真诚赞赏,手留余香」

真诚赞赏,手留余香

使用微信扫描二维码完成支付